虚拟机正在使用或无法连接到

报类似如下错误时

解决方案

首先进入该页面获得虚拟机所在位置

解决方案

首先进入该页面获得虚拟机所在位置

删除.ick后缀的文件,该文件应该是保存了虚拟机上次运行时的运行状态

删除.ick后缀的文件,该文件应该是保存了虚拟机上次运行时的运行状态

然后Ctrl+Alt+Delete键打开任务管理器,键盘敲入v快速查找和Vmware相关的进程,然后结束这些进程,有些进程无法关闭,可以不管。

然后Ctrl+Alt+Delete键打开任务管理器,键盘敲入v快速查找和Vmware相关的进程,然后结束这些进程,有些进程无法关闭,可以不管。

关闭完所有Vmware相关进程后,重启电脑即可进入虚拟机

关闭完所有Vmware相关进程后,重启电脑即可进入虚拟机

开启共享文件夹

进入虚拟机配置页面

设置本地作为共享文件夹的目录

设置本地作为共享文件夹的目录

进入虚拟机页面,使用超级用户权限cd /mnt/hfgs/共享文件目录即可找到共享目录

进入虚拟机页面,使用超级用户权限cd /mnt/hfgs/共享文件目录即可找到共享目录

可本地主机将需分享的文件拖入共享文件夹,虚拟机即可通过上述方式访问并获取共享资源

图形界面的电脑网络连接小图标消失

解决方案

输入service NetworkManager restart重新启动NetworkManager即可,并设置下开机自启动,输入chkconfig NetworkManager on即可

解决方案

输入service NetworkManager restart重新启动NetworkManager即可,并设置下开机自启动,输入chkconfig NetworkManager on即可

ping出现网络不可达

出现如下情况,ping不通其他网站时

原因是,网关设置错误,虚拟机导致无法访问互联网

解决方案

鼠标移动到电脑图标,右键编辑连接

原因是,网关设置错误,虚拟机导致无法访问互联网

解决方案

鼠标移动到电脑图标,右键编辑连接

选择刚才使用的连接设置,点击进入编辑

选择刚才使用的连接设置,点击进入编辑

点击进入配置网关信息,可通过网络适配器查看到网关地址,一般前三个数同ip地址一致,最后一个数字为2,例如192.168.47.2,最后点击应用即可

点击进入配置网关信息,可通过网络适配器查看到网关地址,一般前三个数同ip地址一致,最后一个数字为2,例如192.168.47.2,最后点击应用即可

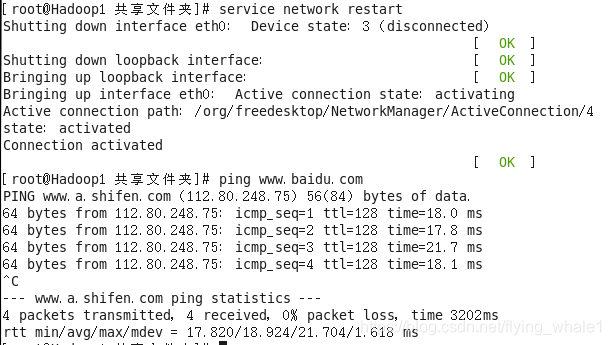

回到命令行窗口,输入service network restart重启网络后,即可ping通了

回到命令行窗口,输入service network restart重启网络后,即可ping通了

如何查看Hadoop的日志文件

1、yum安装的Hadoop,日志文件默认位于/var/log/hadoop-hdfs/、/var/log/hadoop-yarn/、/var/log/hadoop-mapreduce/,根据节点类型查看不同日志,注意查看对应时间的日志文件 2、tgz本地解压安装的Hadoop,日志文件位于Hadoop解压目录下的logs目录里,比如解压位置为/home/hadoop-1.0.0,则日志文件位于/home/hadoop-1.0.0/logs/下

分布式启动namenode失败,日志报java.io.IOException: Failed to load FSImage file错误

解决方案

第一种清除namenode存储的fsimage文件,重新格式化namenode后,即可启动namenode,此方法会清空namenode存储信息。

具体命令如下

解决方案

第一种清除namenode存储的fsimage文件,重新格式化namenode后,即可启动namenode,此方法会清空namenode存储信息。

具体命令如下

| |

第二种是事先备份namenode存储的fsimage文件、datanode存储文件和yarn存储文件信息,然后清除namenode存储的fsimage文件后格式化namenode,最后将备份信息重新复制到namenode、datanode、yarn文件的目录,该方法理论可行,尚未尝试

hdfs操作时出现Unable to load native-hadoop library for your platform… using builtin-java classes where applicable警告

原因:

Apache提供的hadoop本地库是32位的,而在64位的服务器上就会有问题,因此需要自己编译64位的版本。

解决方案:

1、下面链接下载对应hadoop版本编译好的natvie包

http://dl.bintray.com/sequenceiq/sequenceiq-bin/

2、解压至hadoop安装目录的lib/native下

原因:

Apache提供的hadoop本地库是32位的,而在64位的服务器上就会有问题,因此需要自己编译64位的版本。

解决方案:

1、下面链接下载对应hadoop版本编译好的natvie包

http://dl.bintray.com/sequenceiq/sequenceiq-bin/

2、解压至hadoop安装目录的lib/native下

| |

3、配置环境变量

| |

4、使刚才配置的环境变量生效

| |

5、输入hdfs操作检验效果

| |

成功解决

成功解决

待更新中。。。